everyweeks

Die Herausforderung bei Everyweeks war, jede Woche ein Bild, einen Klang oder ein Video zu erstellen. Ich entwickle die Software der algorithmischen Bilder in C++ von Hand. Wenn nicht anders hervorgehoben, können alle Videos als Applikation live und in Echtzeit laufen.

Ich habe im November 2015 mit dieser Herausforderung begonnen aber im Juni 2016 wieder aufgehört, da die Everyweeks anfingen, einen großen Teil meiner Freizeit einzunehmen und ich meine eigentliche Arbeit nicht vernachlässigen wollte. Ich werde stattdessen Skizzen ohne festen Zeitplan unter https://vimeo.com/album/2961417 veröffentlichen.

Im Moment sind viele Beschreibungen der Everyweeks leider nur auf englisch verfügbar.

bitte ein Everyweek über die Miniaturbilder auswählen

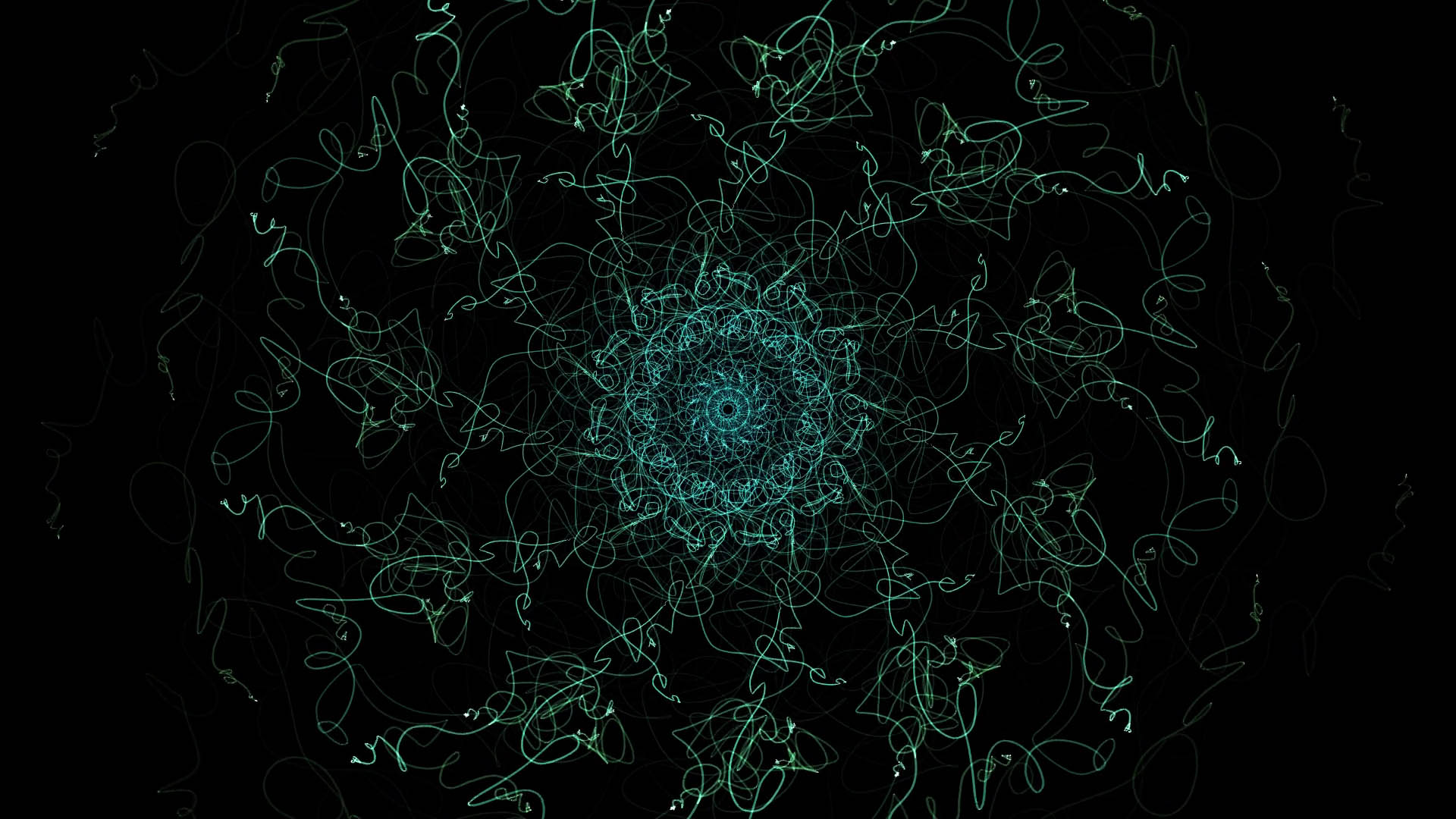

Der Teich

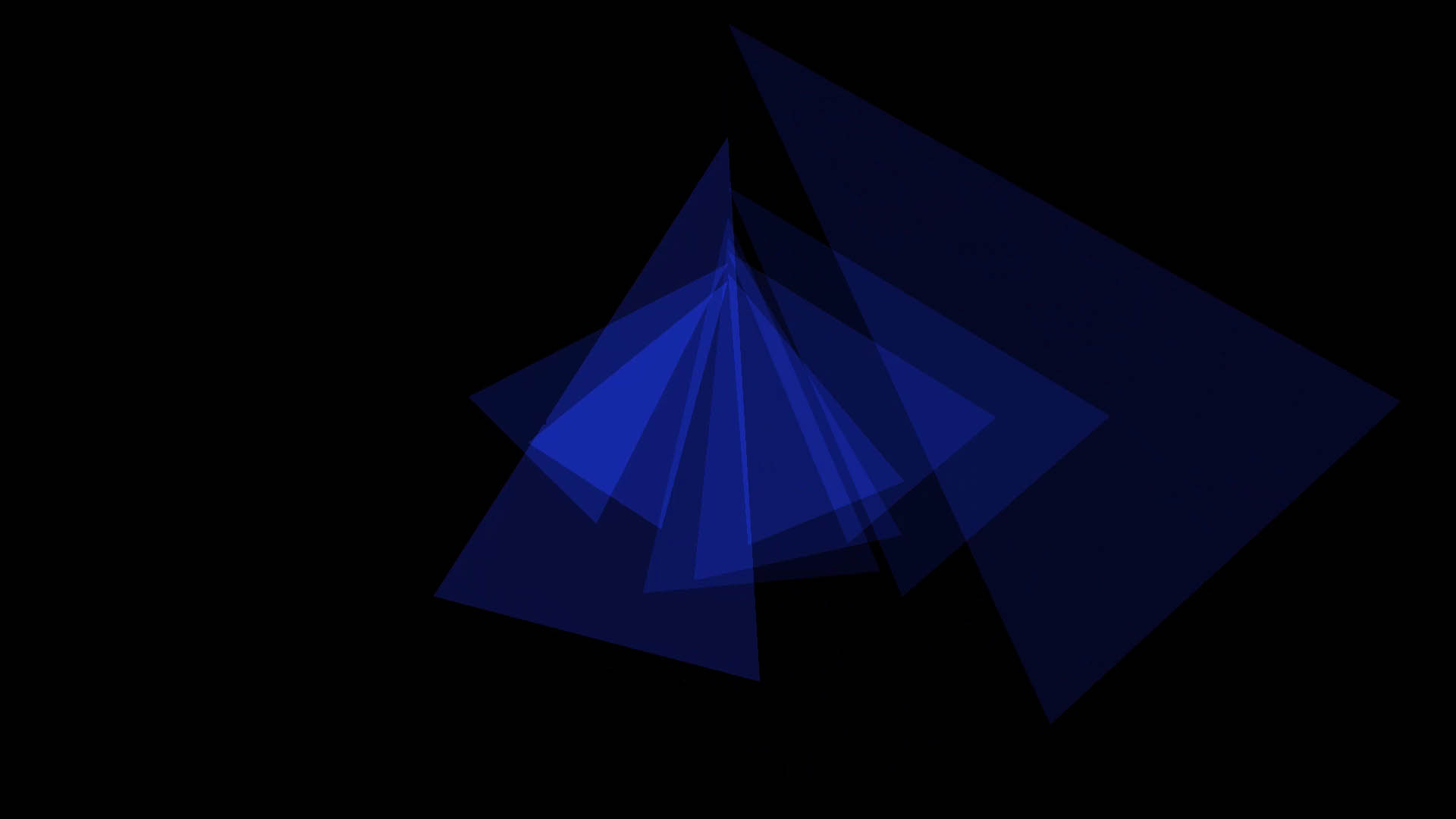

ein kreisförmiges Muster aus Seilen

18.06.2016

Jedes Seil erzeugt eine dreiecksförmige Klangwelle. Jeweils zwei Seile sind auf die Obertöne eines Grundtons gestimmt, inklusive eines negativen Obertons. Tonhöhe und Lautstärkemodulation dieser monophonen Klangwellen werden von den physikalischen Attributen am Kopf eines jeden Seils kontrolliert. Ich habe sogenannte Splines verwendet, um die Simulation zu glätten.

Rose

Rückkopplung

10.06.2016

für Insa

Wildnis

05.06.2016

Auf dem Boden liegen und in den Himmel schauen

Bokeh (Studie 1)

29.05.2016

Dies ist eine erste Studie zur Simulation von Bokeh (die Art und Weise, wie optische Linsen unscharfe Lichtpunkte darstellen).

Ich habe die OpenGL-Shadersprache verwendet, um Punkthelligkeiten eines Lochkamerabildes zu verteilen. Die Tiefe eines Bildpunkts im Lochkamerabild bestimmt die Größe des sogenannten „Zerstreuungskreises“ eben dieses Bildpunktes.

Dieser Ansatz ist sehr langsam und ergibt keine interaktiven Bildraten, da die Shadersprache so konstruiert ist, dass sie viel besser Werte sammeln als verteilen kann. Für den nächsten Ansatz werde ich OpenCL oder eine vergleichbare Sprache verwenden, welche die Verteilung von Werten zulässt.

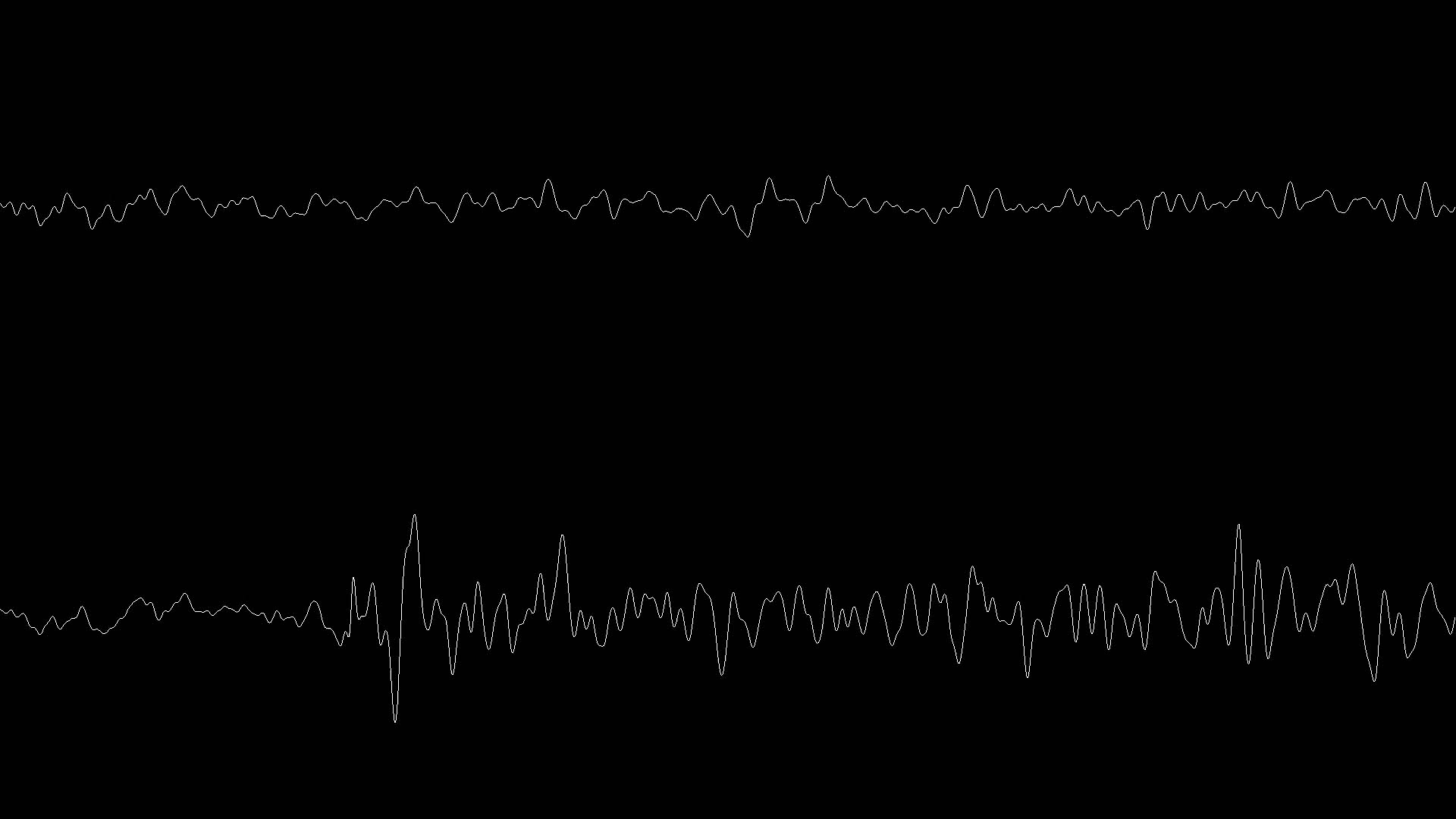

Schwerer Regen

22.05.2016

Dies ist keine Klangaufnahme aus unserem Hinterhof. Es sind 256 kleine, sehr schnell schwingende Seile, die fast klingen wie schwere Regentropfen, die auf ein Dach trommeln.

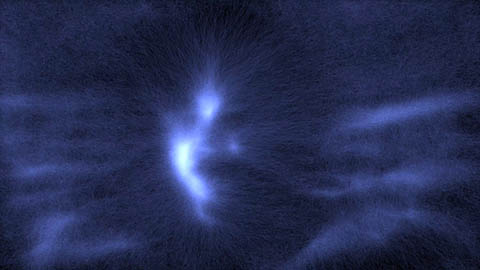

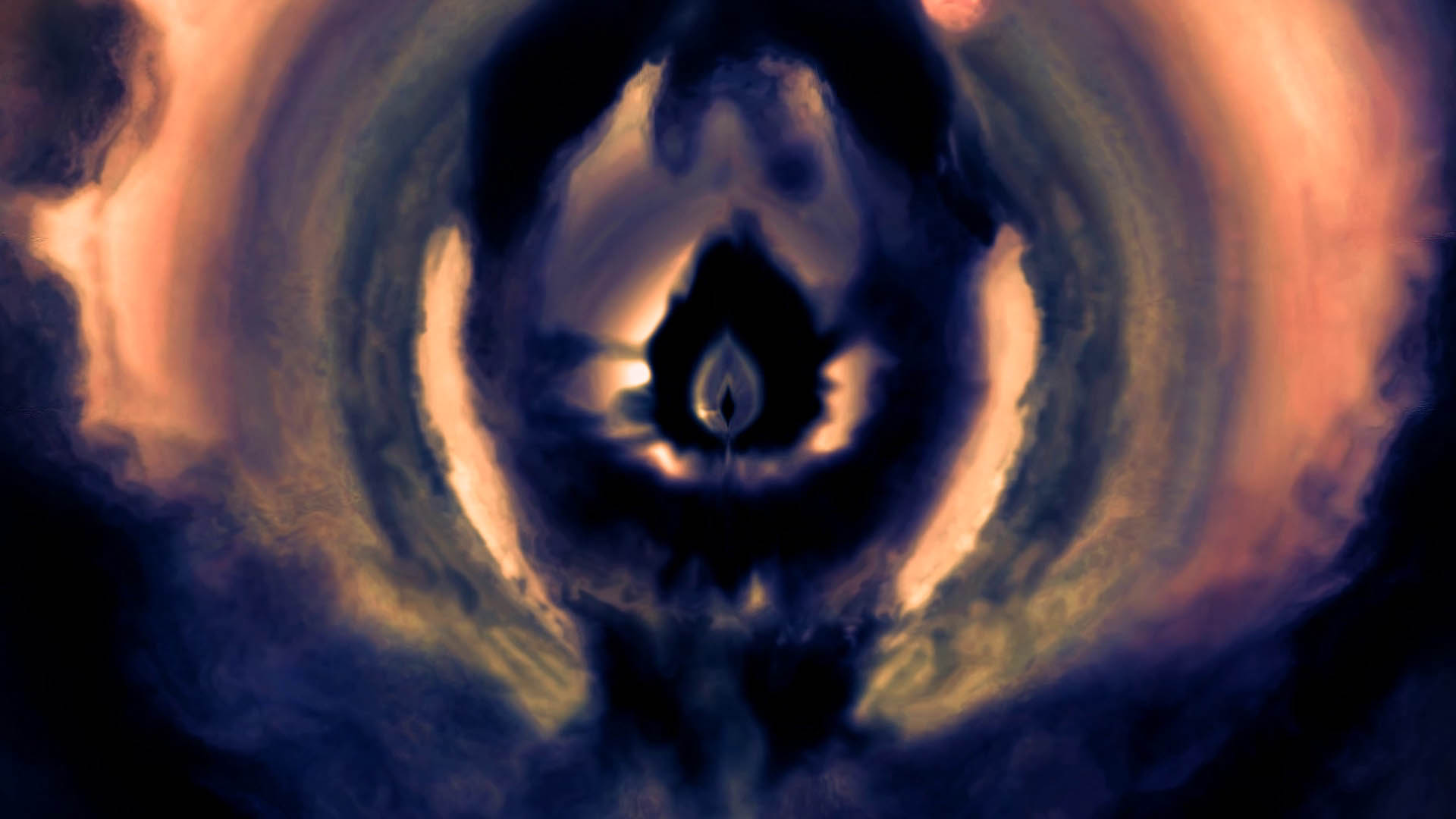

Nebel

ein Nebel aus Rückkopplungen

15.05.2016

Dieser Bild geht zurück auf die Tunnelähnlichen analogen Rückkopplungsschleifen, die man erzeugen kann, wenn man eine Videokamera auf einen Monitor hält, der das Kamerabild selbst darstellt, nur leicht hereingezoomt. Die mögliche Komplexität der resultierenden Bilder hat mich immer schon fasziniert.

Das Problem mit dieser Art von Rückkopplung ist oft, dass der Bildschirm nach einiger Zeit entweder schwarz oder weiß wird. Man kann die Rückkopplung am Leben halten, indem man sie mit einer Art von Bildkeim überblendet, wie ich es hier mit der Kerzenartigen Funktion tue, aber es gibt noch mehr zu tun.

Um die dunklen und hellen Bereiche besser auszubalancieren, fing ich mit der Idee eines „stroboskopischen“ Rückkopplungsschleife an. In jedem digitalen Rückkopplungsschritt wird das Bild vergrößert und invertiert. Um das endgültige Video herzustellen, zeige ich nur jedes zweite Bild, so dass kein Flackern zu sehen ist.

Zusätzlich verzerre ich die Position, an der ich das Bild zurück auslese, basierend auf dem farbigen Bildinhalt - ein Vorgang, der sich in der analogen Welt nur recht schwierig erreichen ließe. Schließlich schärfe und Kolorisiere ich das Bild mithilfe des XYZ Farbraums.

Viel Spaß beim Flug...

Edit: Drei Stunden nach der Veröffentlichung habe ich die Einfärbung noch einmel etwas aktualisiert...

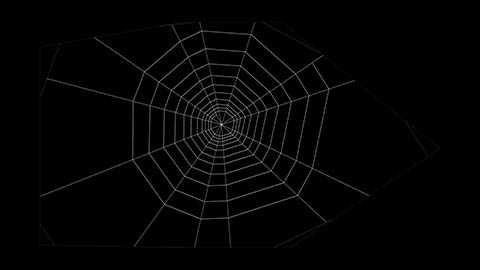

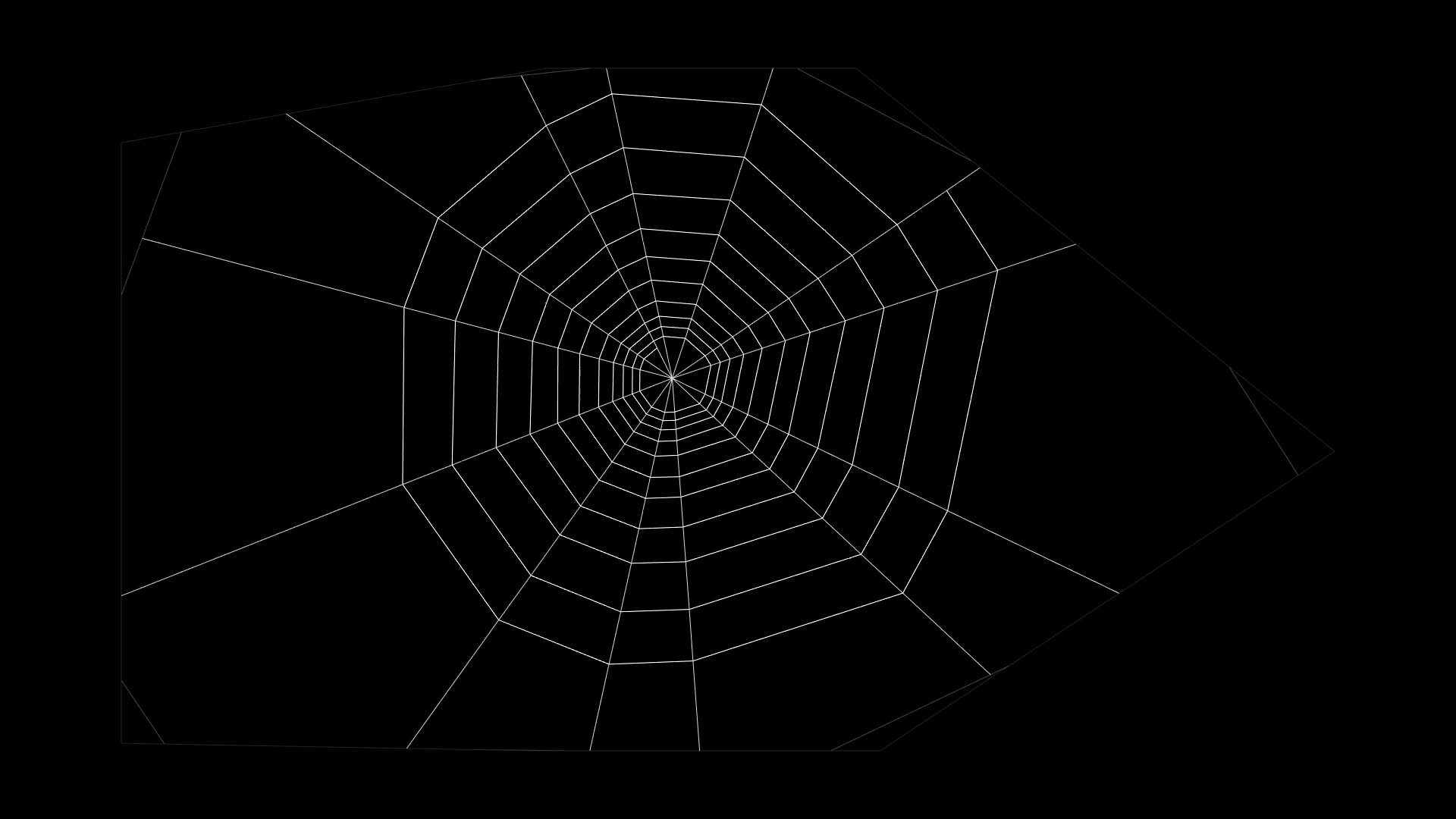

Spinnennetz

künstliche Spinnweben, geeignet für physikalische Modellierung

09.05.2016

...dann wurde es mir klar: Spinnen sind Fischer der Lüfte...

Mein Ansatz entspricht größtenteils dem von Schmitt, Walter und Comba, untersscheidet sich aber insofern, als dass ich ein Netz erzeuge, das für physikalische Modellierung wie Wind usw. geeignet ist. Das bedeutet, ich erzeuge ein Netz miteinander verbundener Knoten, wobei beispielsweise Klebefäden wirklich mit den Radialfäden verbunden sind usw. Im Video habe ich ein wenig Schwerkraft und sanfte Bewegungen im Zentrum der Netze hinzugefügt, um das zu zeigen.

Das Netz wird auf folgende Art hergestellt: Ausgehend von einem Zentrum schieße ich Fäden in die Umgebung, um einen grundlegenden Rahmen von Ankerpunkten zu finden. Dann erzeuge ich zufällig einige unterstützende Fäden. Anschließend schließe ich radiale Fäden von der Mitte und laufe abschließend spiralförmig um die klebrigen Spiralfäden zu erzeugen. Es gibt, wie immer, noch sehr viel zu tun. Aus Zeitgründen habe ich die Reisefäden zwischen den Klebefäden nicht implementiert, die andere Ansätze berücksichtigen.

Dieses Everyweek war verspätet, da ich in der letzten Woche eine schwere Erkältung hatte. Das Netz selbst ist ein Fall von Knoten- und Faden-Indizierungs-Paradies und -Albtraum, also brauchte ich eine ganze Weile um alles richtig hinzubekommen.

Danke an Chris Wening für die Inspiration.

Grillen

Synthetisierter Klang von Grillen in der Dämmerung

01.05.2016

Ich habe den Klang einer Grille synthetisiert. Er basiert auf einer Grille, die wir letztes Jahr nach Sonnenuntergang in der Nähe der Stadt, in der ich lebe, aufgenommen haben.

Für den Grundklang verwende ich vier Obertöne, die ich zusätzlich am Begin jedes Zirpens nach open verstimme. Die Hüllkurve für jedes Zirpen ist eine quadrierte Sinuswelle. Grillen zirpen zwei bis fünf mal in schneller Abfolge, um dann eine kurze - und manchmal viel längere - Pause einzulegen. Schließlich verwende ich einen Tiefpassfilter für weit entfernte Grillen, um atmosphärische Effekte zu simulieren und mehr Tiefe herzustellen.

Besonderen Dannk an Lorenz Schwarz für die Aufnahmen und das genaue Reinhören.

Vögel

24.04.2016

Ich arbeite oft sehr spät nachts und manchmal in den Morgen des folgenden Tages hinein. Zu diesen Gelegenheiten genieße ich das frühmorgentliche Singen der Vögel. Warum also nicht mal versuchen, diesen Moment zu synthetisieren?

Der Klang der Syrinx (das Stimmorgan der Vögel) ist von Wissenschaftlern zu einem sehr überzeugenden Grad hin modelliert worden. Ich verwende hier hauptsächlich das Modell, das von Rodrigo Laje et al. im Jahr 2002 beschrieben wurde, für alle der elf simulierten Vögel. Es ist auf lsd.df.uba.ar zu finden.

Jeder Vogel hat eine spezifische Distanz und Position um den Zuhörer herum. Der Hall wird pro Vogel berechnet und nimmt proportional zu seiner Distanz zu. Ich verwende dann eine einfache volumenbasierte Balance, um die Richtung des Vogels zu etablieren. Schließlich verwende ich einen weiteren Hall um alles in einem einzigen künstlichen Raum miteinander zu verschmelzen.

Der Gesang ist zufällig aber der Singsang der Vögel wurde viel realistischer als ich die Gesangs-, Atem- und Tonhöhenübergangszeiten nicht vollständig zufällig für jeden neuen Zyklus bestimmte. Das Miteinbeziehen früherer Werte in die Berechnungen erlaubte gebündeltere Arrangements von kürzeren und längeren, tieferen und höheren Phrasen.

Bloom

Ein bloom Experiment

15.04.2016

Dieses Everyweek war von der Gruppe „mercury“ inspiriert, die Schimmer (bloom) in einigen ihrer Demoszeneproduktionen verwenden. Eine geradliniger Gaussscher Unschärfefilter mit zwei Durchläufen stellte sich als zu Zeitintensiv für hochauflösende Bilder heraus, also verwende ich den alternativen Ansatz mit verschwommenen Mipmaps.

Während die Hand selbst eine goldene Farbe besitzt, berechne ich die Stärke des Schimmers für rot, grün und blau separat, um einen eher feurig orangefarbenen Rand zu erzeugen. Ich habe den Eingabebildern auch ein wenig Bewegungsunschärfe hinzugefügt.

Glockenläuten

Glockenspiel, das mit additiver Synthese hergestellt wurde

08.04.2016

Für jede Glocke verwende ich sieben Sinuswellen mit zufällig verstimmten Frequenzen und Abklingzeiten. Eine dieser zufälligen Obertöne hat eine Frequenz, die eine Oktave unter der Grundfrequenz liegt. Der Klang jeder Glocke wird ihrer Bewegung entsprechend verstimmt und ich habe ein kurzes Delay verwendet, um einen Phaseneffekt zu erzeugen.

Wie man einen noch glockenähnlicheren Klang erzeugen kann, beschreibt der „Synth Secrets“ Artikel von Sound on Sound: soundonsound.com/sos/Aug02/articles/synthsecrets0802.asp.

Feedback Delay Network

Künstlicher Hall mithilfe eines Feedback Delay Networks (FDN)

03.04.2016

Dieser Hall erzeugt wesentlich weniger Rechenauslastung als meine vorherigen Implementierungen. Hier verwende ich eine Version mit 16 Delayzügen sehr nahe dem FDN design von Jot. Mehr Informationen zu diesem Modell gibt es unter ccrma.stanford.edu/realsimple/Reverb/.

Eine Notiz: Dieser FDN-Hall beinhaltet keine Erstreflektionen (early reflections), also den Klang den die ersten wenigen Reflexionen von Wänden generieren würden. Er simuliert nur den späteren, diffusen Hall. Erstreflektionen können hinzugefügt werden um einen noch realistischeren Hall zu erzeugen.

Danke an Ida Nordpol für die Stimme.

Vocoder

27.03.2016

Vocoder-Effekt unter Verwendung eines Fourier-Transformations-Ansatzes. Der Text ist über das „starke Gesetz kleiner Zahlen“, moduliert vom geräuschhaften Teil der Kaleidoskop Audiospur:

As Richard K. Guy observed in October 1988, "There aren't enough small numbers to meet the many demands made of them." In other words, any given small integer number appears in far more contexts than may seem reasonable, leading to many apparently surprising coincidences in mathematics, simply because small numbers appear so often and yet are so few.

Wie Richard K. Guy im October 1988 beobachtete, "Es gibt nicht genug kleine Zahlen um den vielen Ansprüchen gerecht zu werden, die an sie gestellt werden." In anderen Worten, jede gegebene kleine ganze Zahl erscheint in weit mehr Zusammenhängen als vernünftig zu sein scheint, was zu vielen offensichtlich überraschenden Zufällen in der Mathematik führt, einfach weil kleine Zahlen so häufig vorkommen und doch so wenige sind.

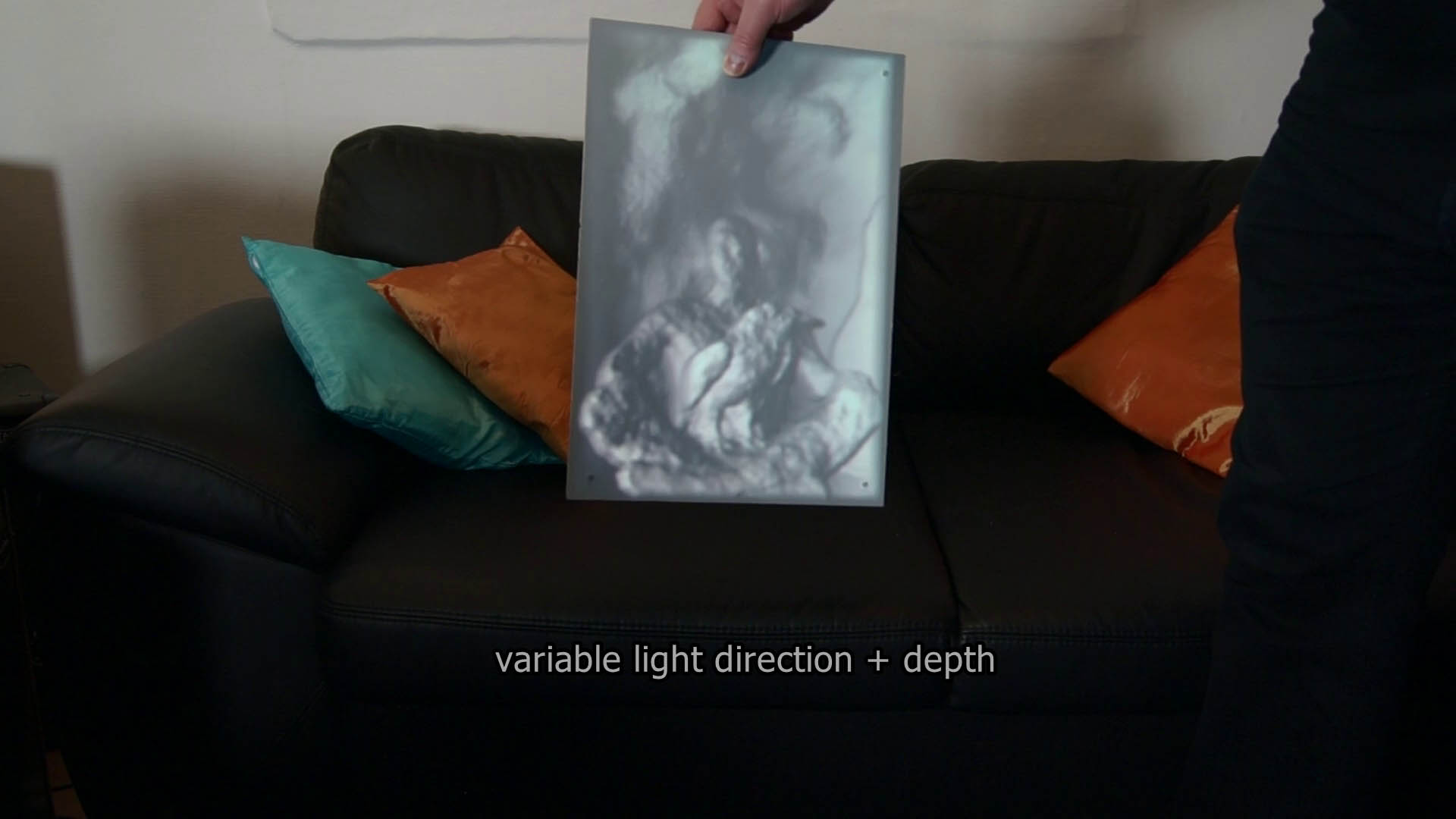

Projektionsmapping

20.03.2016

Eine kurze Demonstration von Projektionsmapping auf eine bewegliche Oberfläche. Ich zeige drei sukzessive Schritte:

- Mapping mit fester Beleuchtung – eine Vorberechnete Textur wird auf die Oberfläche projiziert

- Mapping mit veränderlicher Beleuchtung – Richtungen von Lichtquellen werden in Echtzeit berücksichtigt

- Mapping mit veränderlicher Beleuchtung und Tiefe – Tiefe wird aufgrund einer angenommenen Kameraposition simuliert

Positionstracking findet hier mit Hilfe von drei kleinen Infrarot-LEDs auf dem Brett und einigen modifizierten Playstation 3 eye Kameras mit Infrarotfiltern statt.

Besonderer Dank an Lorenz Schwarz für seine Unterstützung bei der Produktion dieser Aufnahme.

Spirale

13.03.2016

Eine sehr farbenfrohe Spirale.

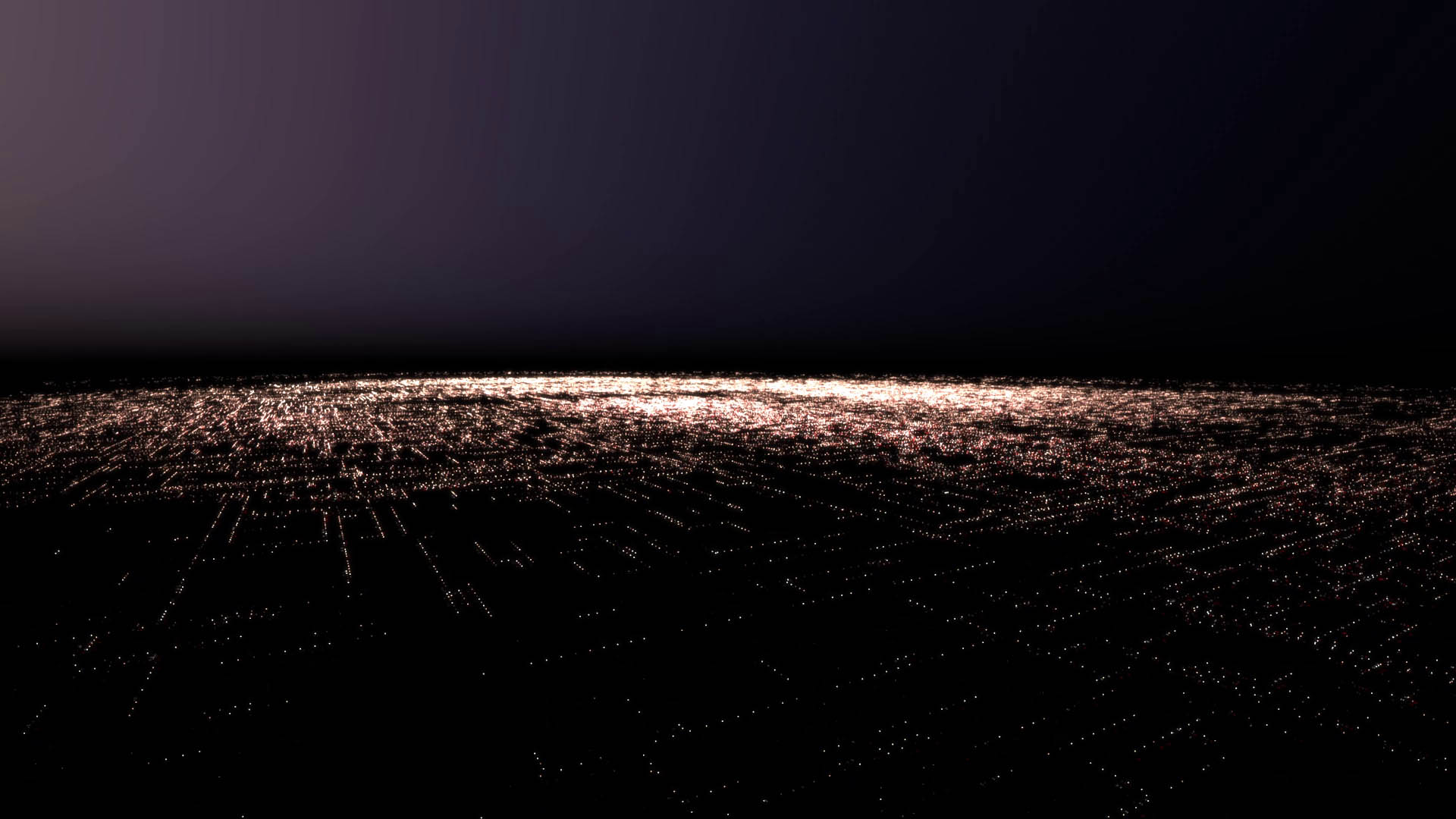

Lichter einer Stadt

06.03.2016

Ein Flug über eine Wüstenstadt, die sich als etwas anderes entpuppt.

P.S. Das endgültige Bild war das einzige, auf das ich kurzfristig zurückgreifen konnte.

Harfe

28.02.2016

Eine künstliche pentatonische Harfe. Die 19 individuellen Saiten der Harfe basieren auf physikalischer Modellierung (Masse-Feder-System). In dieser Bildschirmaufnahme kontrolliere ich sie interaktiv, indem ich meine Hand vor der Kamera bewege. Niedrig klingende Saiten sind links, hoch klingende Seiten rechts positioniert.

Ich verwende Saiten mit derselben Spannung aber varierender Länge (Anzahl der Federn). Der Klang jeder Saite wird durch einen einzigen virtuellen Klangabnehmer recht nah an ihrem Aufhängepunkt erzeugt. Das Bild, das zu sehen ist, besteht aus gefilterten Differenzbildern (d.h. alles, was sich von Bild zu Bild verändert), die die Grundlage für das Tracking der Hand bilden.

Seltsamer Fluss

21.02.2016

Nur etwas mit Halos herumspielen. Die Originalaufnahmen sind vom Fluss Neckar.

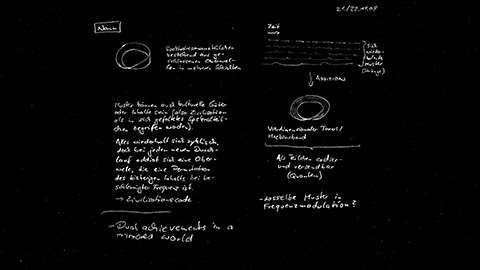

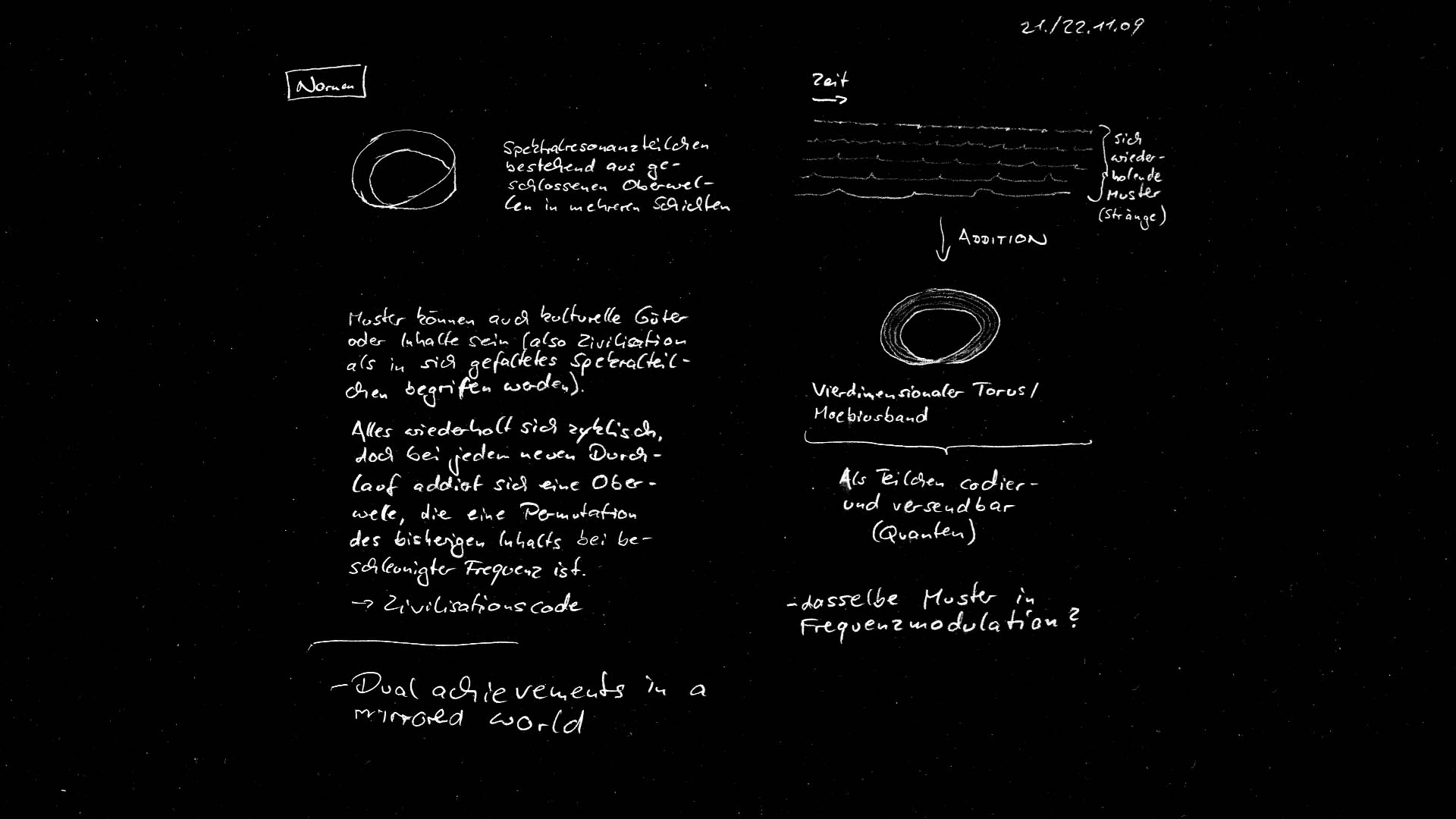

Nornen (Notizen)

14.02.2016

A note on the Norns, from quite a while ago... If our reality was woven by threads, what could they possibly look like? Here I assume that reality is enclosed in a single container of some sort, that reality is encoded as what I call a spectral resonance particle. The following is a direct translation of the text from my note page:

Norns: Spectral resonance particle consisting of closed harmonics in multiple layers

Patterns may also be cultural assets or content (so civilization can be understood as a spectral particle, folded into itself). Everything is cyclically repeating, but with every cycle a harmonic adds up that is a permutation of previous content at an increased frequency.

→ civilisation code

Time → Repeating patterns (strings) → Addition → Four dimensional torus / Moebius strip → Can be encoded and sent as particle (quanta)

- the same pattern in frequency modulation?

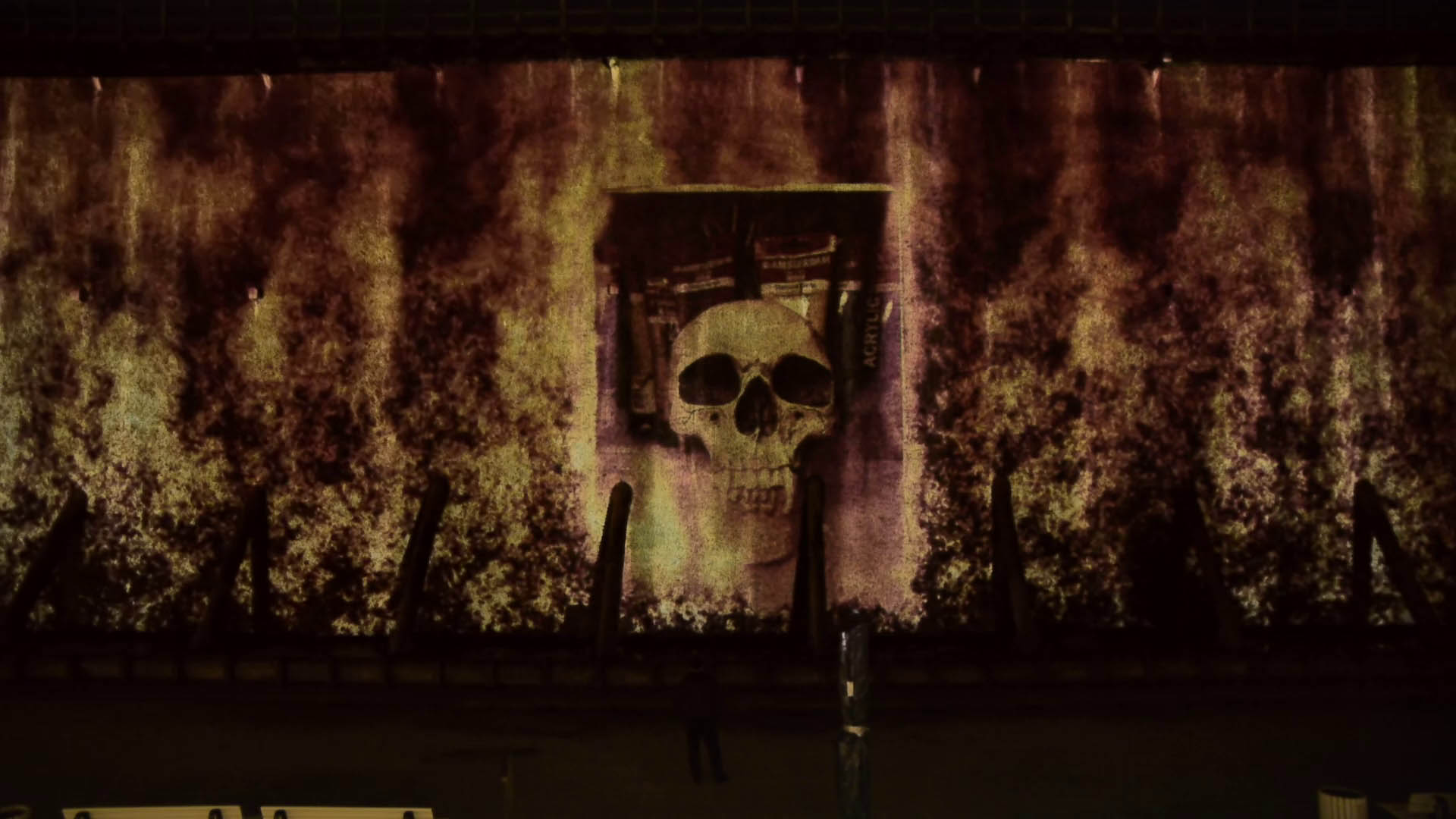

Feuerwall (Vorschau)

07.02.2016

This is a sneak peek on the documentation of my installation "Feuerwall". The installation was part of the fifth lichtsicht projection biennial in Bad Rothenfelde, which ended today.

Camera by Marc Teuscher, skull photo by Ida Nordpol

You can find more information on the installation at foerterer.com/feuerwall and lichtsicht-biennale.de

Nornen

31.01.2016

Three Norns twine the thread of fate, according to German mythology: Wyrd (that which has come to pass), Verðandi (what is in the process of happening) and Skuld (debt, guilt). With this idea in mind, I explored what it would look like if images were woven by threads.

Risse (Studie 2)

24.01.2016

This is the second study of a more complex picture: An ice surface that undergoes endless fractionation without ever breaking completely.

The lines now form indentations of varying with and depth. I added Perlin Noise that zooms and rotates with the lines. The noise delivers the basis for surface parameters like distortion, height, color and shininess.

You can find the first study here: vimeo.com/151312235

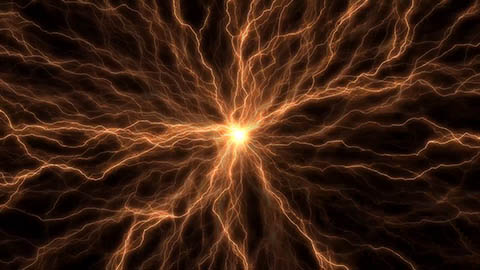

Blitze

Simulation elektrischer Entladungen, die auf Klang reagiert

17.01.2016

Ambient track by Holger Förterer and Ida Nordpol (Vocals, Car Wash) with additional help from Chris Wening. Street recordings are from Karlsruhe in the night of Halloween 2012.

Risse (Studie 1)

10.01.2016

A flight into a surface that slowly cracks up more and more. This is the first study of a more complex picture: An ice surface that undergoes endless fractionation without ever breaking completely.

Depending on the parameters, this picture can look like a flight above fields or rivers, the picture of a retina or plant, or simply cracking ice/rocks.

Inspiration: Ida Nordpol

You can find the second study here: vimeo.com/152907606

Schneekristall

03.01.2016

Happy new year... Winter has finally arrived and I wanted to program a simple snow crystal. I found an algorithm by Gravner and Griffeath at psoup.math.wisc.edu/papers/h3l.pdf that I tried to program in OpenCL. I think there is more left to explore. Great real crystals can be found at snowcrystals.com

P.S. The video is a time-lapse recording, sped up by a factor of 20.

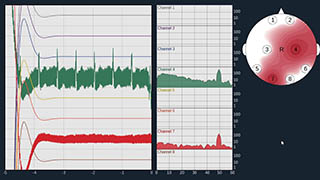

Herzschlag

26.12.2015

In 2016, I want to explore the possibilities of using brainwaves and EKG in the creation of artworks. This video is more of a technical preparation for the things I want to develop later on. What you can see is my heartbeat, captured by an OpenBCI 32-Bit interface (OpenBCI = Open-Source-Brain-Computer-Interface). The noise you see in the beginning is a 50Hz noise from the environment that then gets notch-filtered so that only the heartbeat remains. I then skip through some additional filters for the data.

Technically, I started with some C++/OpenFrameworks code by Daniel Goodwin to interface with my EEG/EKG capture board, then continued to port/adapt some more of the original Java Code of the OpenBCI user interface. I hope to port the full user interface in the coming weeks and publish the code to give others a starting point to use the brainwave hardware with C++/OpenFrameworks.

You can find more information on the OpenBCI hardware at openbci.com

Stoff

18.12.2015

I got captured by the beautiful golden shimmer of an Asian cloth yesterday and try to simulate it here.

Beleuchtung

13.12.2015

Finger exercise: A simple lighting effect that reacts to the loudness of music. I analyze live sound and then feed Art-Net lighting control messages from my software through a grandMA onPC lighting software to control the DMX LED light on the right.

The music is an excerpt of Greg Hunter (DUBSAHARA) Live @ MEME 2013 by MEME Festival and was licensed under a Creative Commons Licence. I downloaded it from soundcloud.com/meme-festival/greg-hunter-dubsahara-live today.

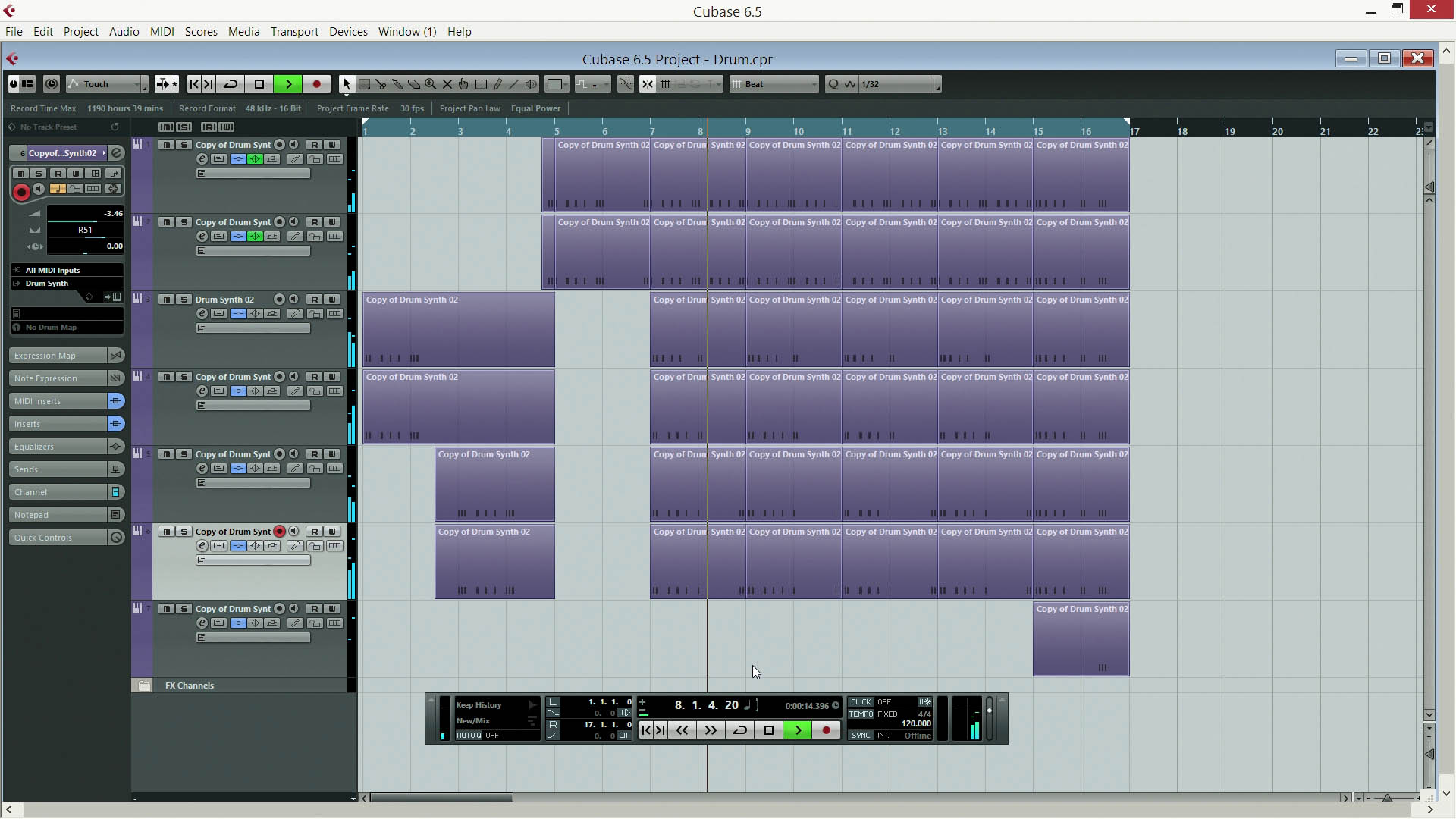

Trommel

06.12.2015

Proof of Concept for a Cubase VST3 Plugin. I wrote a physical simulation for drums and wanted to connect it to Cubase. I am reading note on triggers, simulate the drums and output their sound. This is more or less in preparation for a 64k Demo synth/sequencer, hopefully for later next year.

Blau Orange

27.11.2015

I wondered what else could be done with last week's video. So I stabilized the original video image, blurred, emphasized and shifted the chroma and added some motion blur. The sound is granular synthesis. Most of the approximately 8000 sound sources are controlled by the difference image of the stabilized video.

The original video is at vimeo.com/146579433.

Grüne See

22.11.2015

Frederik Busch took a slow motion video of the stormy Baltic Sea today. The colors were almost completely gray so I tried my DIN99d Lab color system on it to get a better feeling for that color system.

The original video is at vimeo.com/146579433.

Schwarm

15.11.2015

Experimenting with sound again. Every light dot has a sound attached to it. The depth position of the particle is the start position within a long sample, from front to back. To keep calculations simple, I only calculated panning and an approximation of the Doppler effect. The text recording is very old. If I'm not mistaken, I whispered a text by Vilém Flusser.

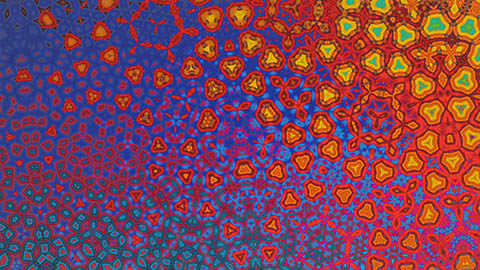

Kaleidoskop

08.11.2015

This is the current state of my fractal caleidoscope effect. It normally uses live video and is best viewed on a wide-gamut TV. I created some quick ambient track with Cubase to put in the background today. The base video is a collection of sweeps across colorful fabric and other pictures.

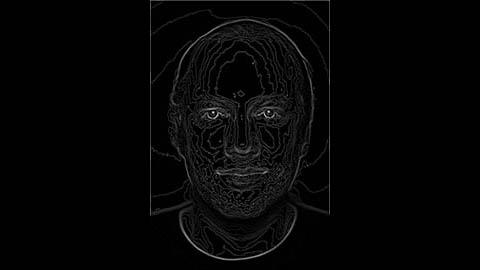

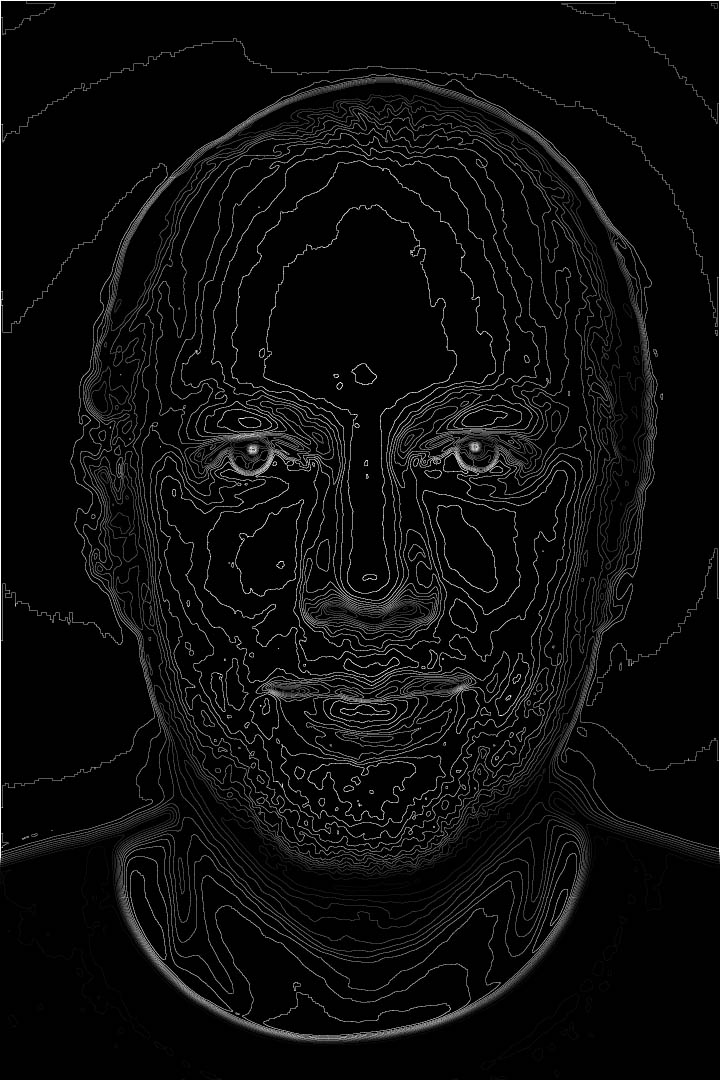

Porträt

01.11.2015

I implemented a Marching Squares contour algorithm lately and thought that playing around with it might do for a beginning. The original Photo was taken by Frederik Busch in 2009.

This is my first "Everyweek". The challenge is to create a picture or sound or video every week.